雷锋网按:在日益变得颠覆的AI背后,总有NVIDIA的影子。

本日上午,作为NVIDIA环球GTC(GPUTechnologyConference)大会中最紧张的一站之一,GTCChina再次在北京召开了。身着标记性玄色皮衣的教主黄仁勋也在本次大会开始之际,奉上了一场题为“一个全新的盘算期间(ANEWCOMPUTINGERA)”的主题演讲。

按照惯例,NVIDIA根本上每年都会将自身紧张的产物发布、软件更新在5月份美国本土召开GTC上公布。而环球其他地区的GTC大会则重要是根据各地区的环境举行微调和“重新演示”,本次的GTCChina亦是云云。

但也正是由于云云,也给了黄教主更多时间去先容NVIDIA本年的新盼望,同时也绝不隐晦的展示出一个结论——

NVIDIA不但仅在AI海潮中,而且是这波海潮得以成型推进的紧张缘故起因。

为什么说GPU是肯定的选择?

性能

这个话题实际上曾出如今本年NVIDIA的数个活动中,就连黄仁勋本身也说了很多遍,正如黄教主本日在Keynote演讲中夸大的那样(牙膏厂跪倒在地):

已往团体行业都是依靠摩尔定律来推动,但它太老了,太慢了,GPU才是全新的"超等摩尔定律",这也是整个行业一次千载一时的机会。

这种性能发展上的差距与串行/并行运行的原理有着直接的关系,终极的结果就像NVIDIA多次展示的那样,在2010年之后,GPU类处理惩罚器内部的晶体管数量还保持着快速增长的势头,而CPU已经出现了显着的放缓。

应用场景

除了性能之外,应用场景的出现则是别的一个紧张的点。尤其是NVIDIA在2008年开始打造CUDA架构之后,GPU的用途已经发生了翻天覆地的变革。而长期以来受限于CPU处理惩罚本领的人工智能也在谁人时候找到了更加得当的源动力,而且依附GPU的性能不绝提拔,极大的拓展了人工智能的本领和实用范围。

正如黄仁勋在此次Keynote中再次提及的部分NVIDIA最新“AI产物”:之前雷锋网(公众号:雷锋网)曾在洛杉矶SIGGRAPH大会上报道过的"InteractiveRayTracing(工业渲染猜测加快)",利用语音就能天生的假造头像,可以或许让游戏假造脚色根据地形做出高度仿真动作的全新算法等等。

不外这些技能和全新算法之以是可以或许成为实际,最关键的缘故起因还是GPU可以或许提供充足的处理惩罚本领。

AI云期间的到来

在此次大会上,黄仁勋也亲身公布了一个紧张的里程碑进度——国内的三大公有云公司:阿里云、百度云、腾讯云均已经引入了NVIDIA的硬件,而且向B端用户开始提供AI相干本领的服务。

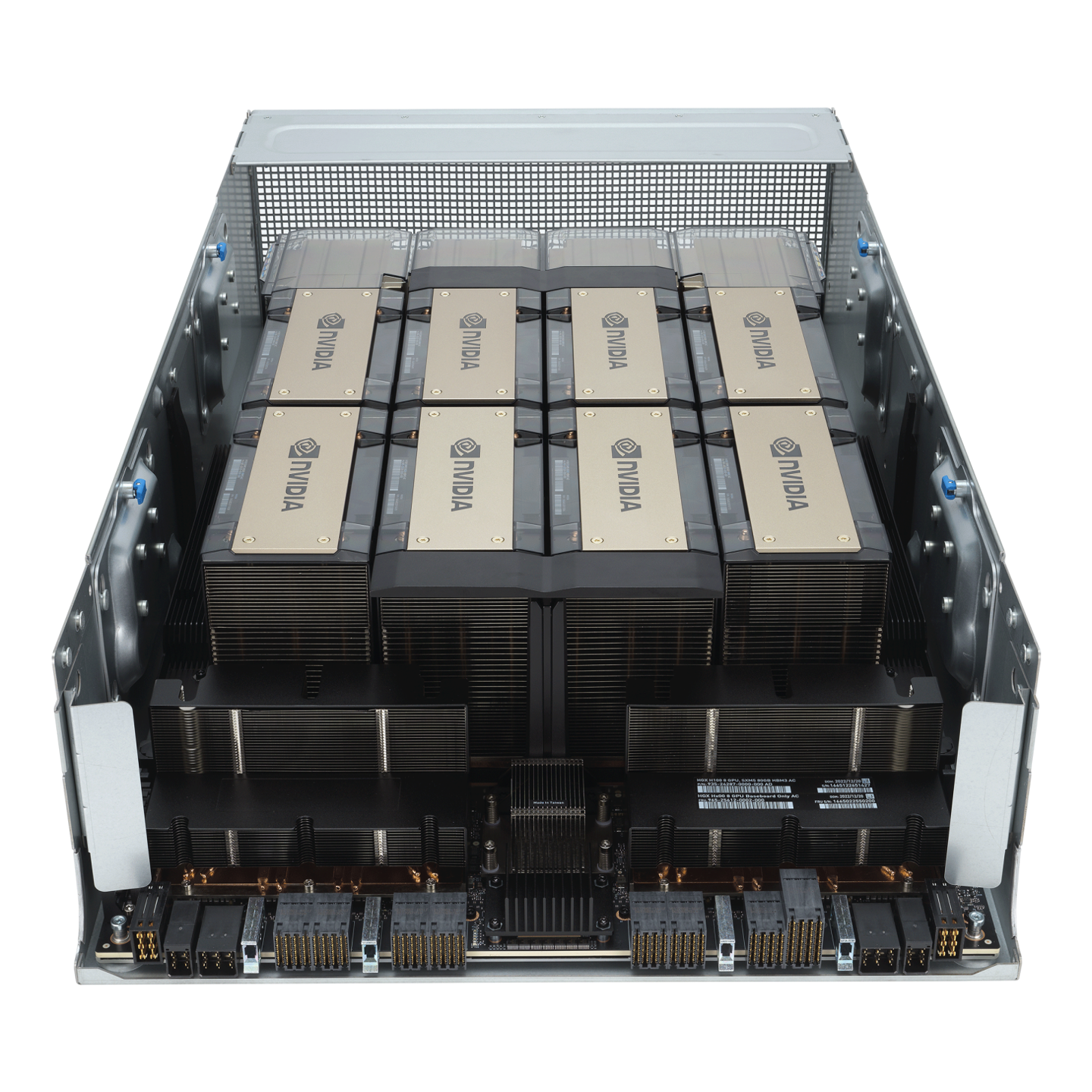

传统CPU方案(上)与NVIDIA方案(下)的对比

这个改变最大的根源实际上是本钱,正如黄仁勋在大会现场举的一个例子:按照传统方案,云服务商可以采购4个机架、共160个CPU服务器,在功耗65千瓦的环境下提供每秒45000张照片的处理惩罚本领。而假如换成NVIDIA的产物,你只必要一个装有8片V100GPU的NVIDIAHGX服务器,同样的每秒45000张照片处理惩罚本领,但是你只必要7个服务器插槽,统共的功耗也只有3个千瓦。

显着的数字对比,背后是巨大的采购和运营本钱差距。换句话说,在AI云处理惩罚需求越来越大的当下,不是服务商选择利用NVIDIA的GPU,而是他们“被迫”利用NVIDIA的GPU。黄教主给出了一个非常精要的总结:

你用的GPU越多,你省的钱越多!(MoreGPU,SaveMoreMoney!)

固然,选择NVIDIA的GPU尚有别的一个紧张缘故起因,5月份的GTC上NVIDIA曾发布了专门用于云端GPU堆栈处理惩罚的技能架构NGC(NVIDIAGPUCloud)。这种技能架构实际上拥有NVIDIA相应处理惩罚器产物的云运营商都有利用,进一步增长了GPU在云端的工作服从和利用率。

NVIDIA=AI海潮的推动者?

就在上周,投行EvercorelSI曾对NVIDIA做出了一个最新的猜测——后者的股价尚有40%的上升幅度,由于投资者仍旧“严峻”低估了人工智能技能的市场。随后NVIDIA的股票随之大涨5%,也算是NVIDIA与AI海潮关系精密的一个侧面证明。

在这次大会上,黄仁勋也“重新发布”了NVIDIAGPU的AI优化技能TensorRT,其关键亮点在于人工智能场景下的巨大提拔。在同样利用全新的V100GPU的环境下,TensorRT相比通用的TensorFlow在图像分析场景下还能提拔19倍之多,在语义分析场景下更是能提拔22倍。

黄仁勋在随后的采访环节也给雷锋网表明了,这种“巨幅”提拔的机密——

固然GPU的绝对性能很紧张,但是怎样将差别的人工智能架构,与差别架构的GPU适配,实际上对后者性能的发挥有着巨大的影响。

左侧是平凡人工智能架构,右侧是TensorRT优化之后的结果

而且TensorRT如今实际已经可以作用于全部常见的人工智能架构,比方:TensorFlow、Caffe2、Chainer、MicrosoftCognitiveTookit、Mxnet、PaddlePaddle、Pytorch、theano。

换个角度来说,NVIDIA实际已经在实行乃至打造出了一套最实用于自身硬件的人工智能架构。也正是由于这个缘故起因,V100才华依附自身出色的性能,以及全新添加的TensorCore,在人工智能的相干场景中得到最出色的表现。

这种在核心硬件性能上的拓展存在于NVIDIA的全部产物线当中,比方NVIDIA为主动驾驶硬件所搭建的DRIVEWorksSDK,可以或许轻松的调用强大的硬件性能处理惩罚各种主动驾驶需求,无论你的传感器是摄像头、毫米波雷达、激光雷达。

别的一个具体例子是呆板人范畴,黄仁勋在此次Keynote演讲中特别提到了主动呆板人方向,他还特别夸大——这很大概是人工智能下一个最紧张的范畴。

而在本年5月的GTC大会中,NVIDIA也放出了一个对应的“大招”:全新的呆板人练习方式“ProjectIsaac”。依附这种全新技能,用户完全不必要再在呆板人实物上举行重复的调试和实行,完全可以将整个场景搬到假造天下当中,而且利用GPU的学习本领,让呆板自行学会最佳处理惩罚方式。

最最最关键的是,由于这种模仿运用的实际上也是NVIDIA的GPU,以是它所天生的算法完全可以或许移植到NVIDIAJetson如许的终端AI芯片平台之上,直接让终端的呆板人依附之前学习的履历运行。

平台战略,爱

从别的一个角度来看,NVIDIA在2017年的诸多AI范畴更新实际可以概括为一句话——做的越来越多,做的越来越全。

比方上文提到的TensorRT,它实际上在各大人工智能架构和NVIDIA的硬件之间搭起了一座“桥梁”。但为什么NVIDIA还要支持这么多种类架构?为什么NVIDIA不本身选择大概打造一套架构?

答:平台战略。这同时也是本日黄仁勋在媒体群访环节提到次数最多的四个字。用黄仁勋本身的话来说:

众人拾柴火焰高,有些事必要各人一起来做。

回到上面的AI架构类题目,打造出CUDA架构的NVIDIA实际上是有机遇创建本身的人工智能架构、乃至参考苹果,推出本身的相应的体系,将整个体系的核心部分渐渐闭环,进而加强自身的掌控力。

如今NVIDIA正在相助的主动驾驶创业公司

但究竟是,NVIDIA从人工智能技能最早期就跟环球的各大着名高校有相助,支持他们举行相应技能的开辟;在主动驾驶范畴,利用NVIDIADRIVE套件的初创公司已经到达了145家,同时宝马、大众、本田等一批传统车企也和NVIDIA保持着精密的相助关系;假如算上其他范畴,如今NVIDIA本身的Inception创业公司筹划的环球规模已经到达了1900家。

而云云广泛相助的出发点着实也很简单,黄仁勋在采访环节直接说了出来:

NVIDIA提供的是平台,也就是说NVIDIA的平台可以让其他的人去创业,去实现本身公司的空想。

假如说上面这句话还略显含糊,那么黄仁勋在采访环节中答复别的一个竞争性的题目时,则更加直接说出了他本身的想法:

NVIDIA正在做的这些奇迹,没有爱是无法做成的。无论人工智能、主动驾驶这些奇迹哪一个做成了,我都会很开心。

在他说出“爱”的那一刹时,这个穿着玄色皮衣的“核弹教主”真的有点萌。

附:黄仁勋媒体群访摘录

问:自主呆板的期间什么时间才会到临?

黄仁勋:自主呆板它必要办理的是三大根本的题目,第一个是为这些主动自主呆板打造一个雷同于人工智能的平台,第二个题目是给自主呆板有一个假造的、来学会做呆板人的这种环境,第三个题目是我们要想办法把大脑放到自主呆板人的框架内里去。NVIDIA来岁年初大概就会开端把这三个题目办理好,10-15年之后,各人会看到巨大的变革。

问:您以为GPU将来可以覆盖全部的场景,还是说在GPU之外尚有更多的场景,更多的CPU也会制造出来,形成我们终极将来盘算的一个模式?

黄仁勋:起首GPU不会更换CPU,它是携手和CPU共同工作的,这也是我们为什么把它称之为加快器,CPU是通用型的,什么场景都可以实用。但是GPU在一些专门的题目上是能量非常大的。它的性能要比CPU高出10倍,50倍乃至百倍。因此,我们就以为究竟上最美满的架构是什么呢?起首我们要把万事皆能的CPU,在加上在某些庞大盘算挑衅方面非常有能量的GPU。以是NVIDIA终极的选择是——我们不会做那些每一次好一点点的通用性的处理惩罚器,而是要做在一些专门的范畴,性能极好的处理惩罚器。后者实际上就是CUDA。

问:假如非要选一个,您以为将来在人工智能范畴是GPU紧张还是FPGA紧张?

黄仁勋:起首两者差别非常大,FPGA非常机动,你乃至可以把它用到网卡里,但是GPU没有这么大的机动性,它只是一种并行盘算的加快器。以是GPU是术业有专攻。以是在三年前我们做了一个决定,把我们GPU做成Tensor实行处理惩罚器,如今已经成为天下上最良好的Tensor处理惩罚器。

问:NVIDIA跟大众如许的车企有相助,也投资了图森将来和景驰如许的公司,你们对于相助是怎么思考的?

黄仁勋:起首我们在相助过程中,不是赌钱,更不思量胜负。NVIDIA提供的是平台,也就是说NVIDIA的平台可以让其他的人去创业,去实现本身公司的空想。我们盼望各人都乐成。以是NVIDIA作为一家平台供应商,我们的任务是不绝的让这个平台与时俱进,让它做得更好,让它不绝的进步。NVIDIA绝对不是一个自闭的公司,也不是一个做垂直集成的公司,NVIDIA是一家开放平台型的公司。NVIDIA做得这个奇迹没有爱是无法做成的。

问:NVIDIA还会投资哪些公司?您下一个筹划改变的行业是哪个?

黄仁勋:NVIDIA所提供的是如许的一个平台,我们提供的平台是针对全部的事物。固然我们也有重点,我们关心几个垂直范畴,此中一个就是人工智能,尚有一个就是交通运输行业。假如你问我们将来NVIDIA尚有哪些器重的行业?固然医疗卫生大概康健财产是我们非常器重的。在这里我们信托我们可以资助康健财产实现厘革。比方新药研发、药物的临床实行、乃至是人群的病症研究等等。

问:您怎么对待中国的人工智能崛起?

黄仁勋:中国本身在盘算机科学方面就是环球一流的。比如腾讯、阿里巴巴、百度,他们都是天下一流公司,又比如李飞飞,她不但仅是我的好朋侪,更是天下一流的人工智能科学家,以是我非常看好中国。由于中国的盘算机整个财产的技能程度,本身就到达天下一流。

作者:李赓

我要评论